Var bor din AI? En guide till fem sätt att driftsätta AI modeller

Publicerad 3 juli 2025 av Joel Thyberg

AI är överallt, eller hur? Det känns som att man varje dag hör om nya AI-agenter, smarta "copilots" och system som ska revolutionera hur vi jobbar och lever. Men har du någonsin stannat upp och funderat på vad det faktiskt betyder? När en app använder AI, var sker magin? Var bor själva AI-hjärnan?

Att förstå det här är en av de viktigaste sakerna att ha koll på just nu. Svaret på den frågan påverkar nämligen allt:

- Kostnaden för tjänsten.

- Säkerheten för din data.

- Prestandan – alltså hur snabbt och bra allting fungerar.

Idag ska vi avmystifiera exakt detta. Vi går igenom de fem vanligaste sätten att driftsätta en AI-modell, från din egen dator hela vägen ut till de massiva datacenter som drivs av techjättarna.

Innan vi börjar: Några nyckelbegrepp

För att hänga med behöver vi snabbt reda ut några centrala begrepp.

1. Parametrar

Parametrar är den absolut viktigaste komponenten i en AI-modell – det är här all dess "kunskap" finns lagrad. Man kan likna dem vid synapserna i en mänsklig hjärna. En hjärna med få synapser kan inte tänka lika komplext som en hjärna med väldigt många. På samma sätt är en AI-modell med fler parametrar generellt sett mer kapabel och "smartare".

Få parametrar (synapser) leder till enklare tankemönster.

Få parametrar (synapser) leder till enklare tankemönster.

Många parametrar (synapser) möjliggör komplexa resonemang.

Många parametrar (synapser) möjliggör komplexa resonemang.

Antalet parametrar anges ofta direkt i modellens namn. Till exempel betyder Llama-3.1:8B att modellen har 8 miljarder (B for billions) parametrar. Som jämförelse uppskattas den välkända modellen GPT-4 ha över 1000 miljarder (en biljon) parametrar.

Det som i slutändan avgör hur "smart" modell du kan köra lokalt är mängden VRAM ditt grafikkort har.

2. GPU

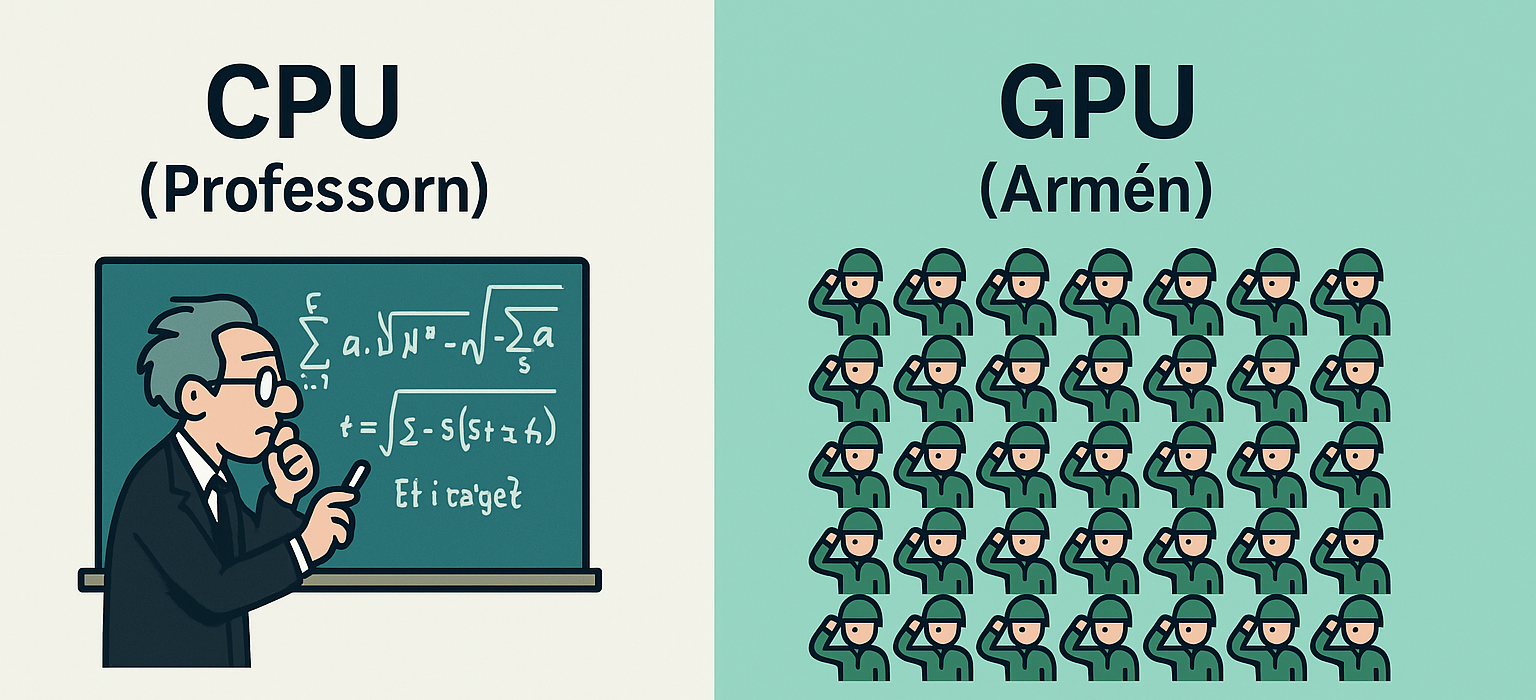

För att förstå VRAM måste vi först förstå vad ett grafikkort, eller GPU (Graphics Processing Unit), gör. Tänk dig skillnaden mellan en professor (CPU) och en armé (GPU).

En CPU (Central Processing Unit), som finns i alla datorer, är som professorn: extremt smart och kapabel att lösa svåra, komplexa problem, men bara ett i taget. En GPU är istället som en armé. Varje enskild soldat är inte lika smart som professorn, men eftersom de är tusentals kan de tillsammans lösa enorma mängder enkla problem exakt samtidigt (parallellt). AI-beräkningar består just av miljontals enkla operationer som måste ske samtidigt, vilket gör GPU:er perfekta för jobbet.

VRAM (Video Random-Access Memory) är GPU:ns eget, supersnabba arbetsminne. Det är här all information som GPU:n behöver omedelbar tillgång till måste finnas. För AI innebär detta att hela modellens alla parametrar måste få plats i VRAM samtidigt.

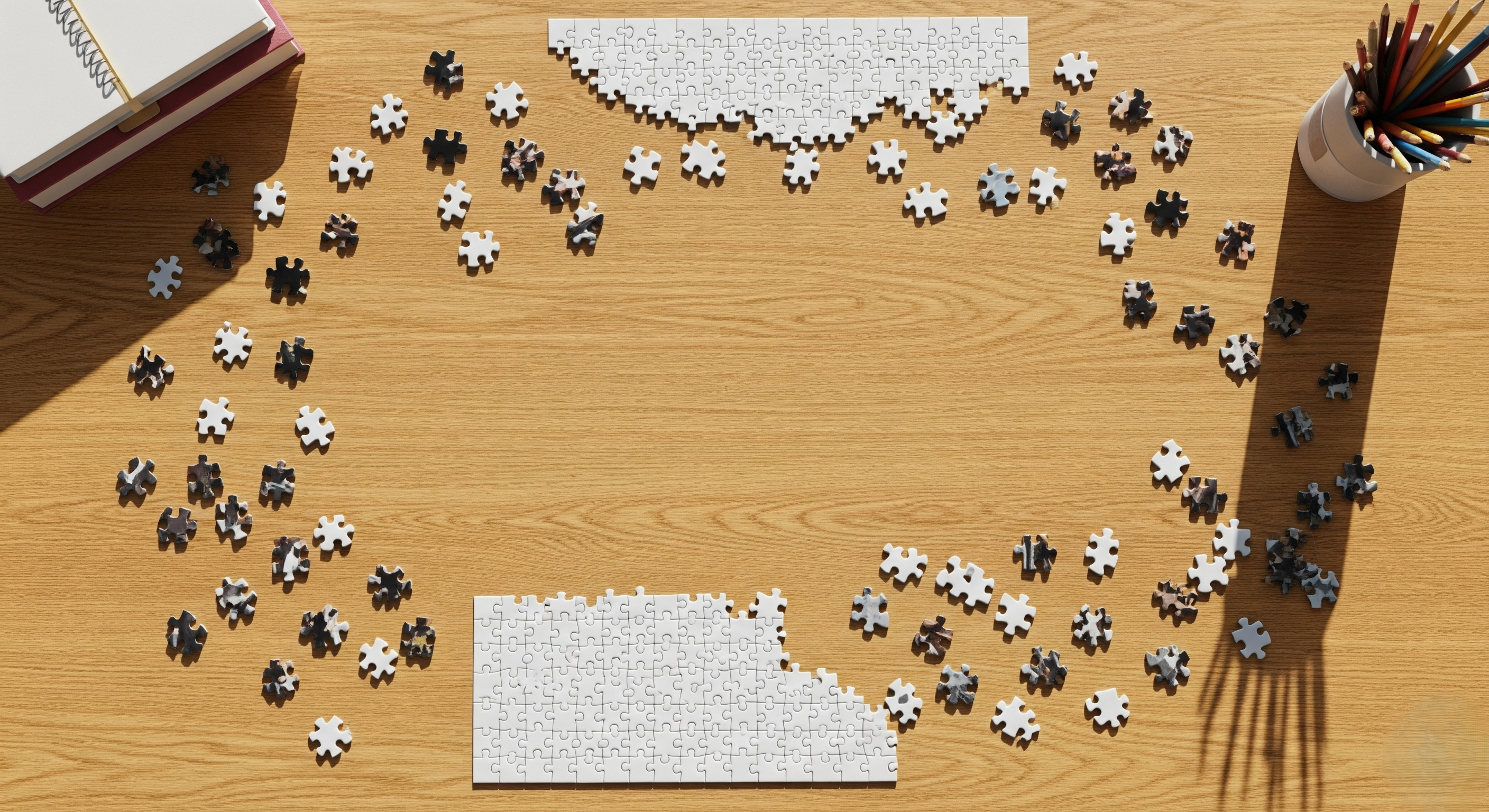

Vi kan likna det vid att lägga ett pussel. Parametrarna är pusselbitarna och VRAM är ytan på ditt skrivbord.

Om inte alla pusselbitar (parametrar) får plats på skrivbordet (VRAM), går det inte att lägga pusslet.

Om inte alla pusselbitar (parametrar) får plats på skrivbordet (VRAM), går det inte att lägga pusslet.

Om alla pusselbitar får plats går det utmärkt att lösa uppgiften.

Om alla pusselbitar får plats går det utmärkt att lösa uppgiften.

Om ditt VRAM (mätt i Gigabytes, GB) är tillräckligt stort för att hålla modellens alla parametrar (också mätt i GB), kan du köra den. Annars går det inte.

3. Server

Enkelt förklarat är en server en dator som är optimerad för ett enda syfte: att "servera" data och tjänster till andra datorer (klienter) dygnet runt, året om. Man har ofta tagit bort allt onödigt som en vanlig användare interagerar med, som skärm, tangentbord och mus. Varje gång du besöker en hemsida, streamar en film eller skickar ett mail, kommunicerar din enhet med en server någonstans i världen.

4. API

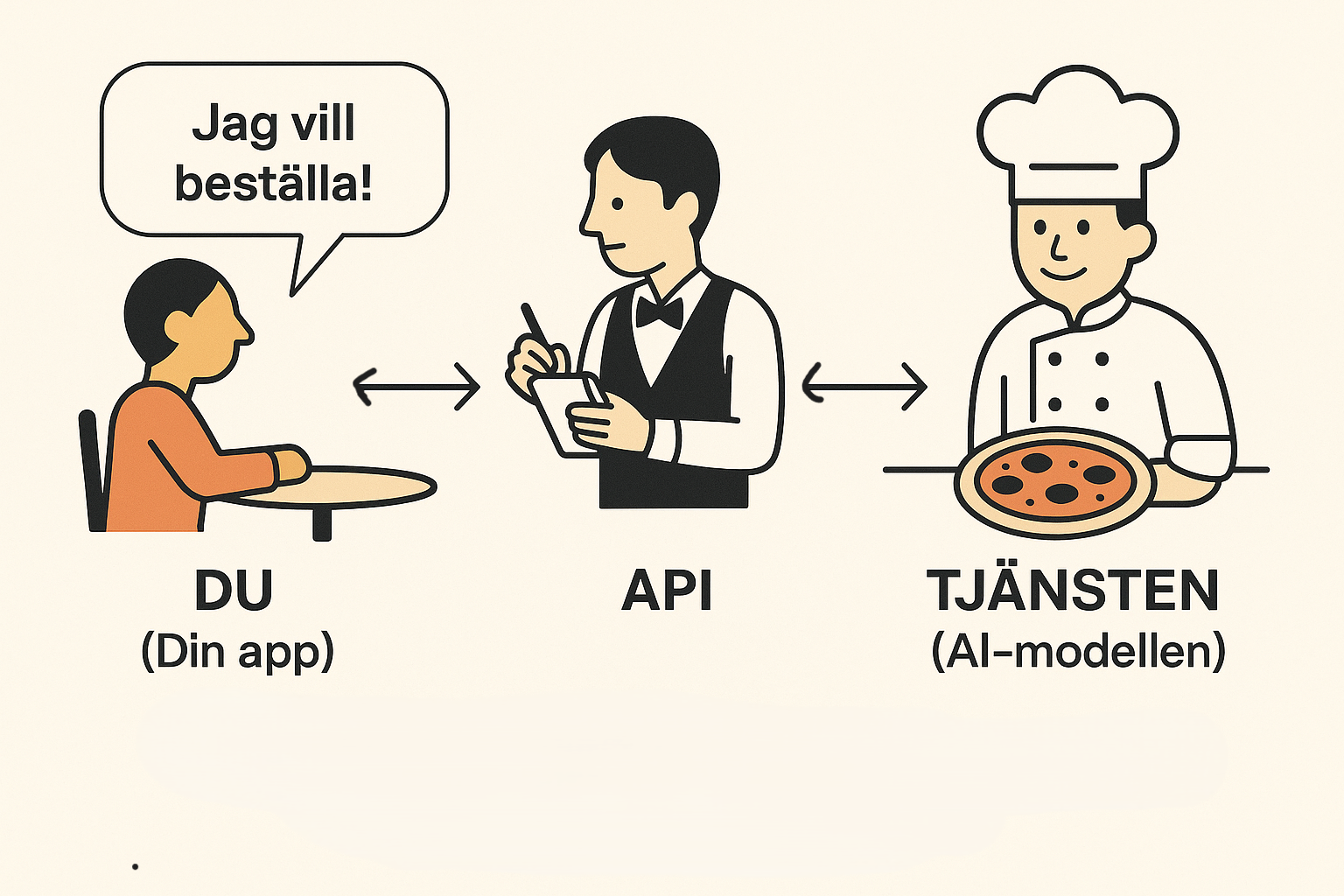

Ett API (Application Programming Interface) är en digital budbärare som låter olika program prata med varandra. För AI-tjänster är detta den vanligaste metoden för att ge användare tillgång till en modell som körs på en server. Låt oss använda en restaurang-analogi:

- Gästen (Du/Din App): Du anländer till restaurangen med ett behov – du är hungrig och vill ha mat.

- Menyn (API-dokumentation): Du får en meny som beskriver exakt vad köket kan laga. Detta är som leverantörens instruktionsbok som säger: "Här är funktionerna vi erbjuder och så här ber du om dem."

- Servitören (API:et): Du gör en beställning från menyn. Servitören tar din specifika förfrågan, validerar den ("Är detta en giltig rätt från menyn?") och levererar den till köket.

- Köket (AI-modellen): Köket tar emot beställningen och tillagar maten. AI-modellen tar emot din förfrågan och genererar ett svar.

- Servitören (API:et): Slutligen bär servitören ut den färdiga rätten från köket tillbaka till ditt bord. API:et levererar det färdiga svaret från AI-modellen tillbaka till din applikation.

Alternativ 1: Helt Lokalt på din Enhet

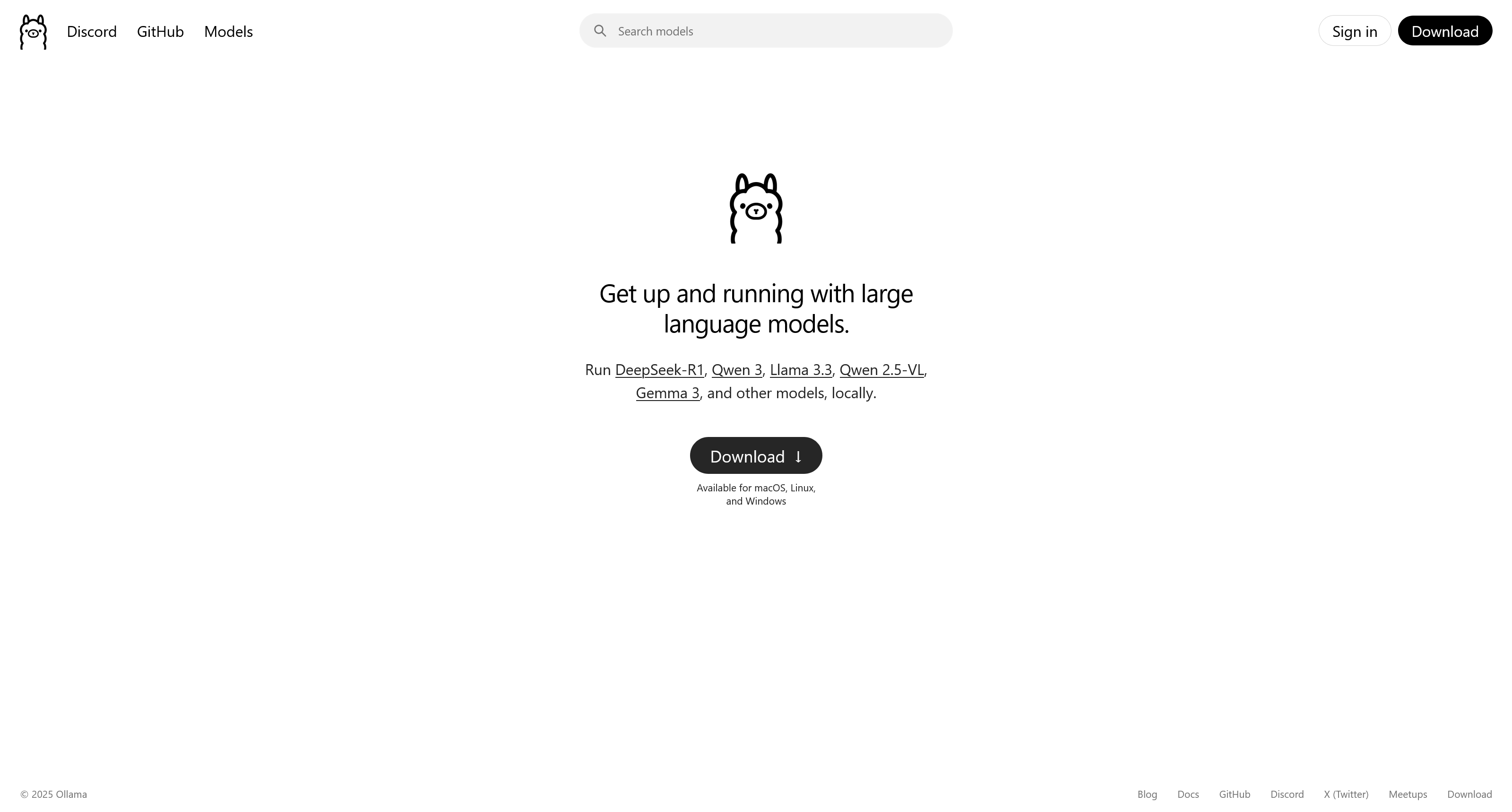

Det första, och för många det mest lockande, alternativet är att köra en AI-modell direkt på din egen dator. Tack vare verktyg som Ollama har denna process blivit förvånansvärt enkel. Så här går det till:

Steg 1: Ladda ner Ollama Besök Ollamas hemsida och ladda ner programvaran för ditt operativsystem.

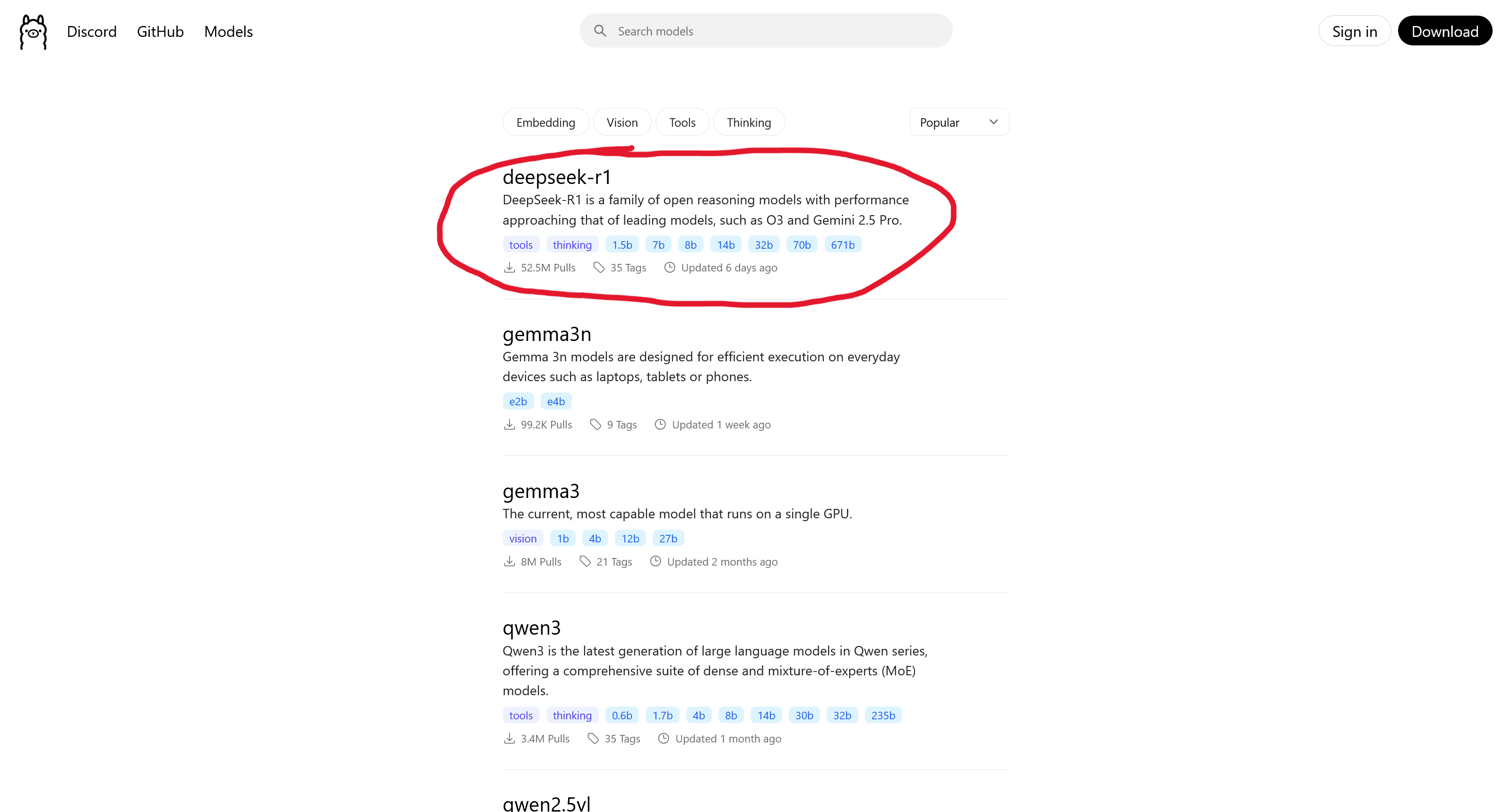

Steg 2: Välj en modell Bläddra bland hundratals modeller på Ollamas hemsida eller på en annan stor modellsamlingsplats som Hugging Face.

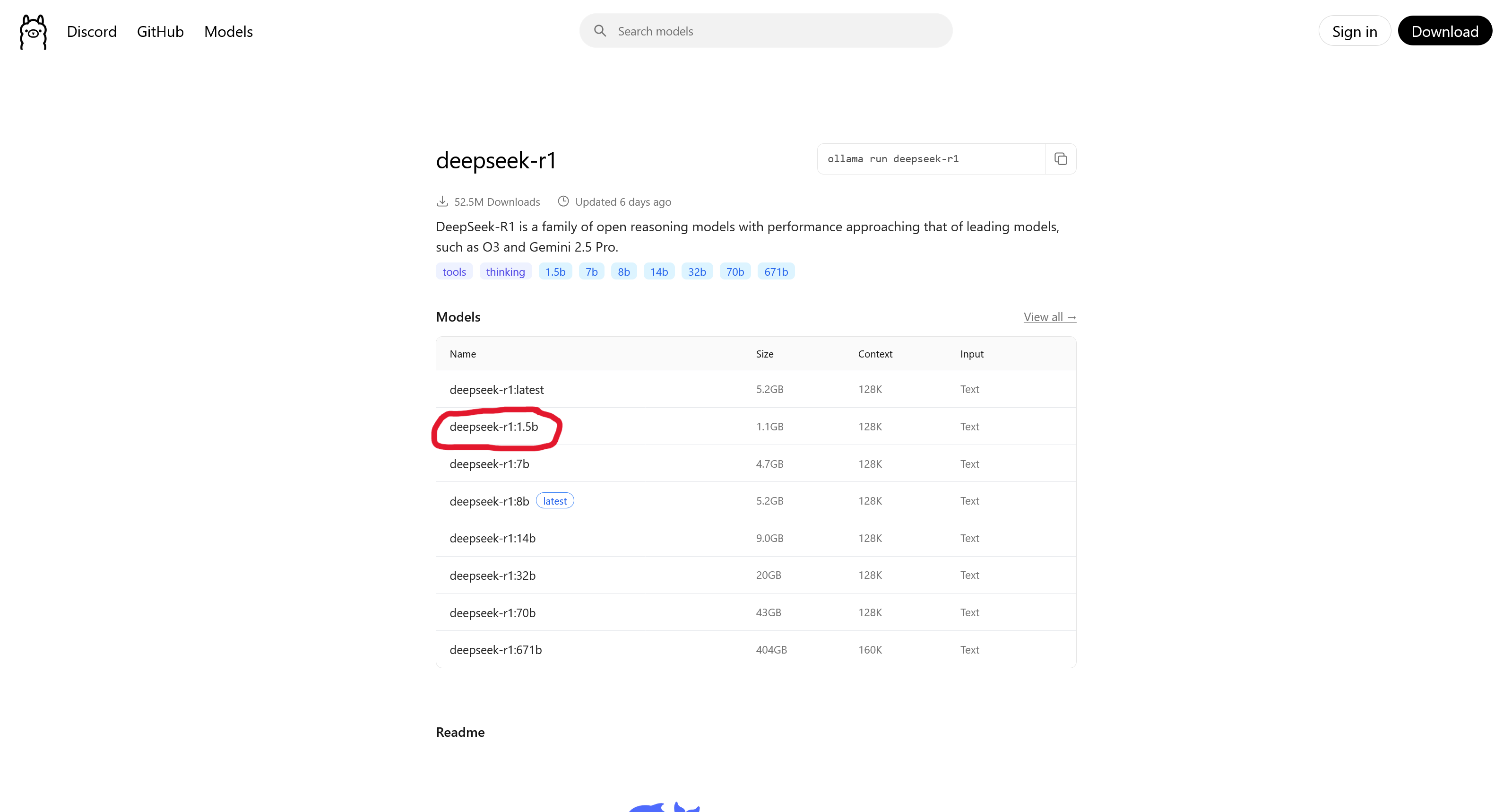

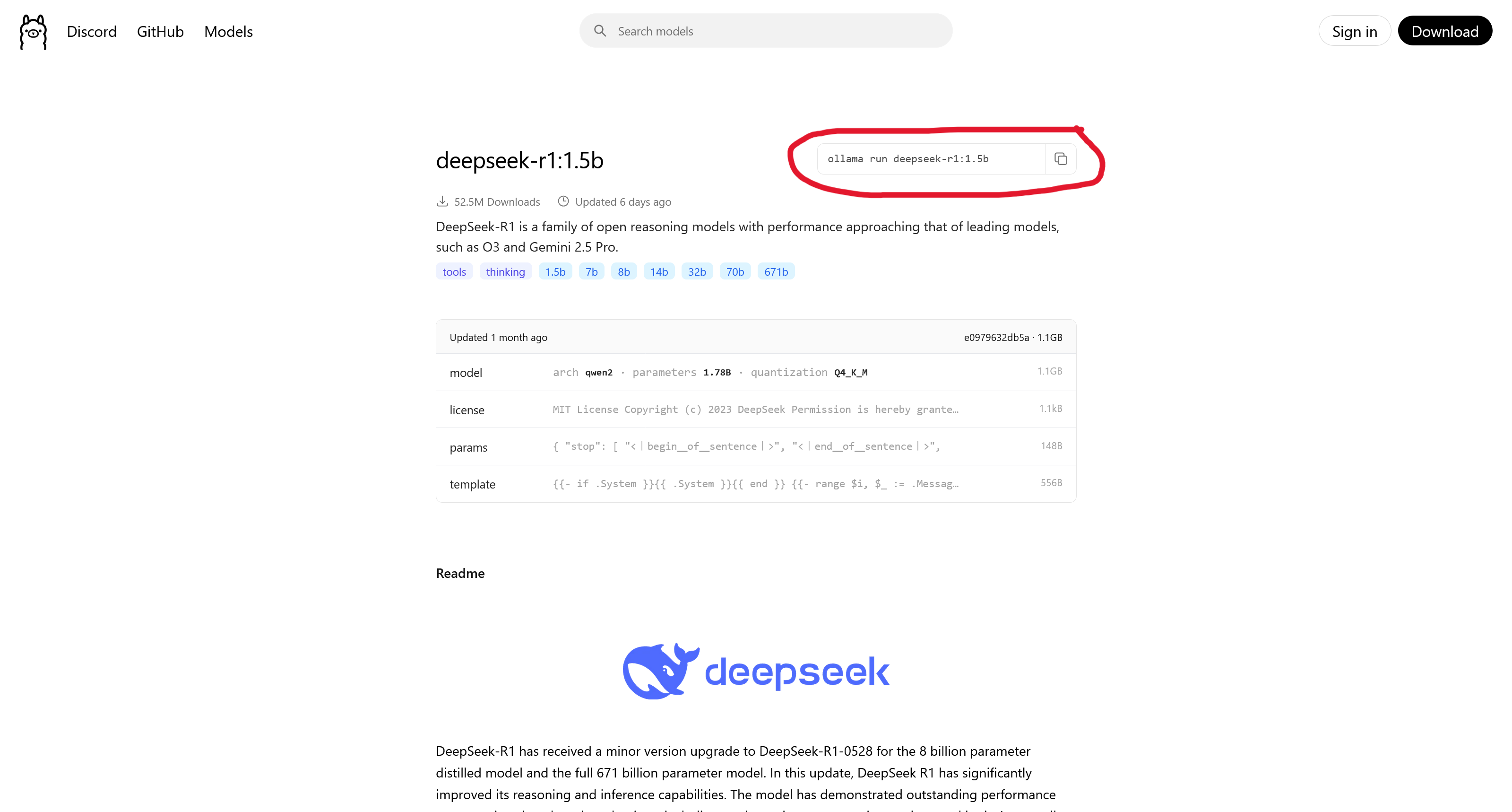

Steg 3: Välj version och kopiera kommandot När du har hittat en modell, gå till dess sida, välj en specifik version (tagg) och kopiera installationskommandot.

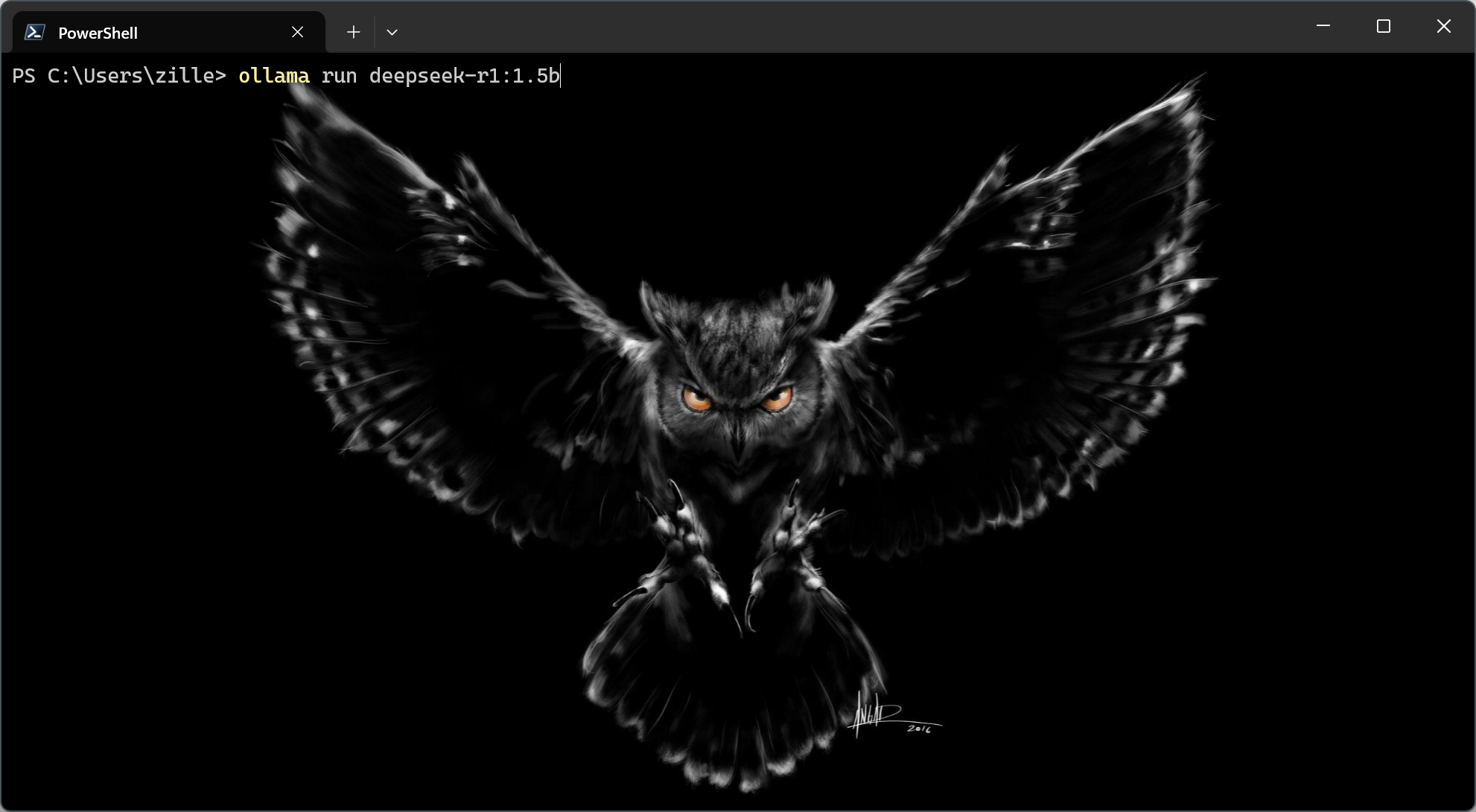

Steg 4: Kör kommandot i din terminal Öppna terminalen på din dator, klistra in kommandot och tryck Enter. Modellen laddas nu ner.

När nedladdningen är klar och du ser texten >>> Send a message (/? for help), är du redo att börja chatta med din lokala AI!

Fördelar

Fördelarna med denna metod är uppenbara:

- Sekretess & Säkerhet: All data stannar på din dator. Ingenting skickas över internet. Det här är det absolut säkraste alternativet.

- Offline-åtkomst: Du behöver ingen internetuppkoppling för att köra modellen.

- Kostnad: Det är gratis! Modellerna är oftast open source, så det enda som kostar är din dator och den el den förbrukar.

Nackdelar

Men det finns såklart nackdelar, och den största stavas hårdvara.

- Krävande Hårdvara: Att köra en AI-modell lokalt kräver betydande datorkraft, framför allt från grafikkortet (GPU) och dess minne (VRAM). Ju större och smartare en modell är, desto mer VRAM krävs för att den ens ska kunna starta. Här är en ungefärlig guide:

| Modellstorlek | VRAM (ca) | Dator & Kostnad (ca) |

|---|---|---|

| 7 miljarder | 8–10 GB | En vanlig, modern gamingdator (10 000–15 000 kr) |

| 13 miljarder | 16–20 GB | En kraftfullare entusiastdator (20 000–30 000 kr) |

| 70 miljarder | 40–48 GB | Professionell workstation, ofta med två GPU:er (40 000 kr +) |

| >100 miljarder | 80+ GB | Dedikerad AI-server (100 000 kr +) |

-

Stora Filer & Krånglig Hantering: AI-modeller är inte små program. En enda modellfil kan vara allt från 4 till över 50 gigabyte stor. Det tar tid att ladda ner och tar upp mycket utrymme. Om flera personer ska använda modellen måste alla ladda ner den, och att se till att alla har rätt och uppdaterad version kan snabbt bli krångligt.

-

Begränsad Tillgång & Juridiska Ramar: De modeller du kan ladda ner lokalt är nästan uteslutande open source. Även om många är fantastiska, finns de absolut mest kraftfulla modellerna (som GPT-4o och Claude 3.5) inte tillgängliga för nedladdning. Utöver detta kommer de modeller du kan ladda ner med juridiska villkor. Bara för att en modell är gratis betyder det inte att du får göra vad som helst med den. Var alltid noga med att kontrollera licensen:

- MIT / Apache 2.0: Mycket tillåtande. Du kan i princip använda, modifiera och sälja produkter som använder modellen.

- Llama 2/3 License: Tillåter kommersiell användning, men med en viktig gräns: har din tjänst över 700 miljoner månadsanvändare måste du skaffa en speciallicens från Meta.

- Creative Commons (Non-Commercial): Vissa modeller får inte användas i kommersiella produkter, utan är endast för forskning.

Alternativ 2: Egen Server (Köpa vs. Hyra)

Nästa steg upp från att köra lokalt på enskilda datorer är att centralisera kraften till en enda, dedikerad server. Detta öppnar upp för två huvudsakliga vägval, som bäst kan liknas vid att köpa ett hus på landet kontra att hyra en lägenhet i stan.

Att köpa (On-premise): Som ett hus på landet. Du äger allt och har full kontroll, men också fullt ansvar för underhåll som el, kyla och säkerhet.

Att köpa (On-premise): Som ett hus på landet. Du äger allt och har full kontroll, men också fullt ansvar för underhåll som el, kyla och säkerhet.

Att hyra: Som en lägenhet. Du bestämmer över din egen yta, men delar infrastruktur (som nätverk och kyla) med andra och fastighetsägaren sköter underhållet.

Att hyra: Som en lägenhet. Du bestämmer över din egen yta, men delar infrastruktur (som nätverk och kyla) med andra och fastighetsägaren sköter underhållet.

Låt oss bryta ner vad dessa två vägval innebär i praktiken.

Underalternativ 2A: Att Köpa en Server (On-premise)

Här köper du in hårdvaran och placerar den i dina egna lokaler. När servern väl är installerad och konfigurerad fungerar det precis som i alternativ 1: du har full kontroll att ladda ner och köra vilka modeller du vill.

Fördelar:

- Full Datakontroll: Detta är den största fördelen. När servern står i din egen byggnad har du total fysisk och digital kontroll. Ingen data lämnar någonsin dina lokaler, vilket ger maximal säkerhet och integritet.

- Centraliserad Hantering: Istället för att installera och uppdatera AI-modellen på tio olika datorer, behöver du bara hantera den på ett enda ställe. Det sparar enormt med tid och säkerställer att alla använder samma version.

- Stöd för Svagare Enheter: Eftersom all tung beräkningskraft finns i servern kan dina användare ansluta med i princip vilken enhet som helst – en enkel laptop, en surfplatta eller en mobil – och ändå få tillgång till AI:ns fulla kraft.

Nackdelar:

- Hög Startkostnad: Att köpa in en server som är tillräckligt kraftfull för att köra stora AI-modeller är en enorm investering. Vi pratar ofta om hundratusentals kronor bara för hårdvaran.

- Kräver Teknisk Expertis: Du är ansvarig för allt: installation, underhåll, kylning, strömförsörjning och fysisk säkerhet. Det kräver en dedikerad IT-avdelning med specialistkunskap.

- Beroende av Lokalt Nätverk: Även om du inte behöver internet, måste alla enheter ha en stabil och snabb anslutning till ert lokala nätverk för att kunna kommunicera med servern. Om nätverket ligger nere, gör även AI-tjänsten det.

Underalternativ 2B: Att Hyra en Server

Här hyr du en virtuell server med en kraftfull GPU från en specialiserad leverantör. När du har skapat ett konto och "startat" din hyrda server, loggar du in och installerar den mjukvara och de modeller du behöver, precis som på en fysisk dator.

Fördelar:

- Ingen Stor Startinvestering: Istället för att köpa en dyr server betalar du en löpande månads- eller timkostnad. Det gör det mycket enklare att komma igång och är snällare mot kassaflödet.

- Enorm Flexibilitet: Detta är en superstyrka. Du kan börja med en mindre GPU och enkelt skala upp till den absolut senaste och kraftfullaste modellen på marknaden för ett kortare projekt, och sedan skala ner igen. Du är inte låst till hårdvara som blir gammal.

- Inget Fysiskt Underhåll: Leverantören sköter all hårdvara, alla reparationer, all kylning och all säkerhet i sina datahallar. Du kan fokusera helt på din mjukvara och dina AI-modeller.

Nackdelar:

- Högre Långsiktig Kostnad: Om du har ett konstant och långvarigt behov kan de löpande hyreskostnaderna över flera år bli högre än vad det hade kostat att köpa servern från början.

- Minskad Datakontroll: Även om du har exklusiv tillgång till din hyrda server, ligger din data fysiskt hos en tredje part. För de allra flesta är säkerheten utmärkt, men det är tekniskt sett en lägre grad av kontroll än att ha servern i ditt eget låsta rum.

- Beroende av Leverantör: Din tjänst är beroende av att din leverantör har bra prestanda, inga driftstörningar och inte plötsligt höjer priserna eller ändrar sina villkor.

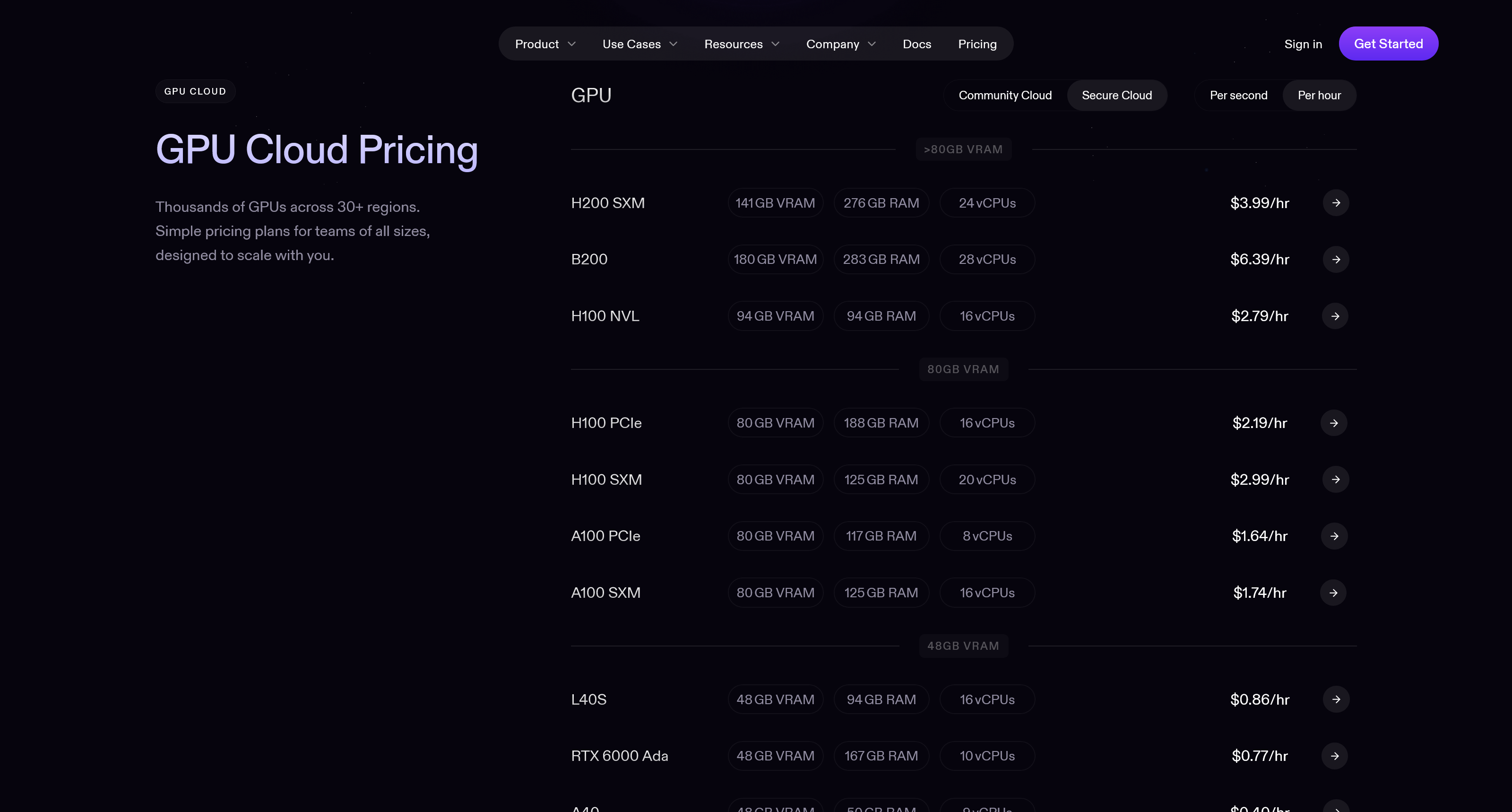

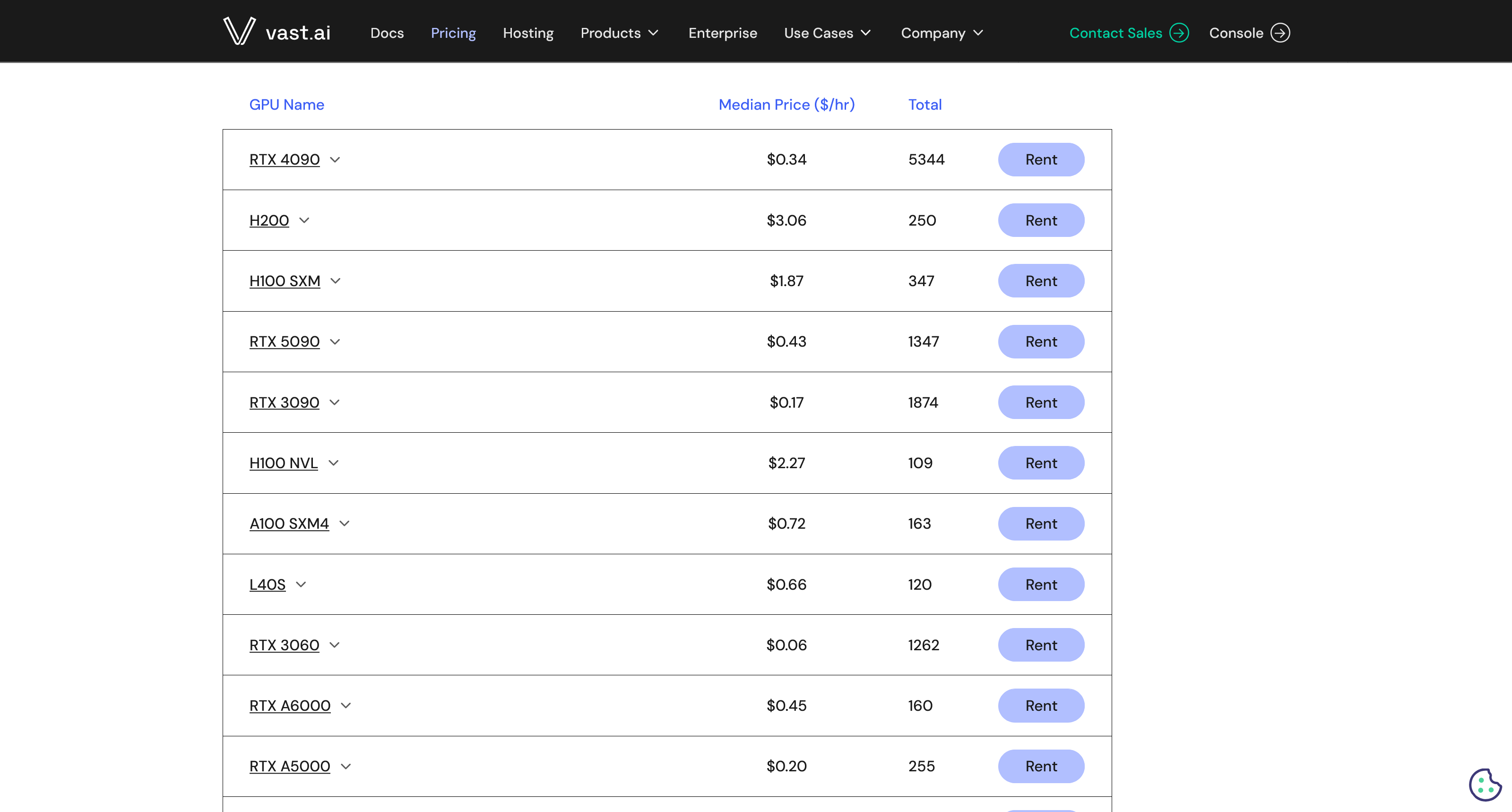

Leverantörerna för att hyra servrar kan se olika ut. Vissa, som RunPod, erbjuder GPU-servrar i säkra, centraliserade datahallar. Andra, som Vast.ai, fungerar som en marknadsplats där vem som helst kan hyra ut sin datorkraft, ofta till ett lägre pris men med varierande tillförlitlighet.

RunPod: Centraliserad och säker uthyrning.

RunPod: Centraliserad och säker uthyrning.

Vast.ai: Decentraliserad marknadsplats.

Vast.ai: Decentraliserad marknadsplats.

Alternativ 3: Specialiserade "Inference" API-leverantörer

Nu lämnar vi världen där vi själva hanterar hård- och mjukvara. Detta är det första alternativet där vi inte längre laddar ner AI-modellen själva. Istället förlitar vi oss på en specialiserad leverantör som har gjort grovjobbet åt oss. De har laddat ner massor av populära open source-modeller, installerat dem på optimerade servrar och gjort dem tillgängliga för oss via ett API.

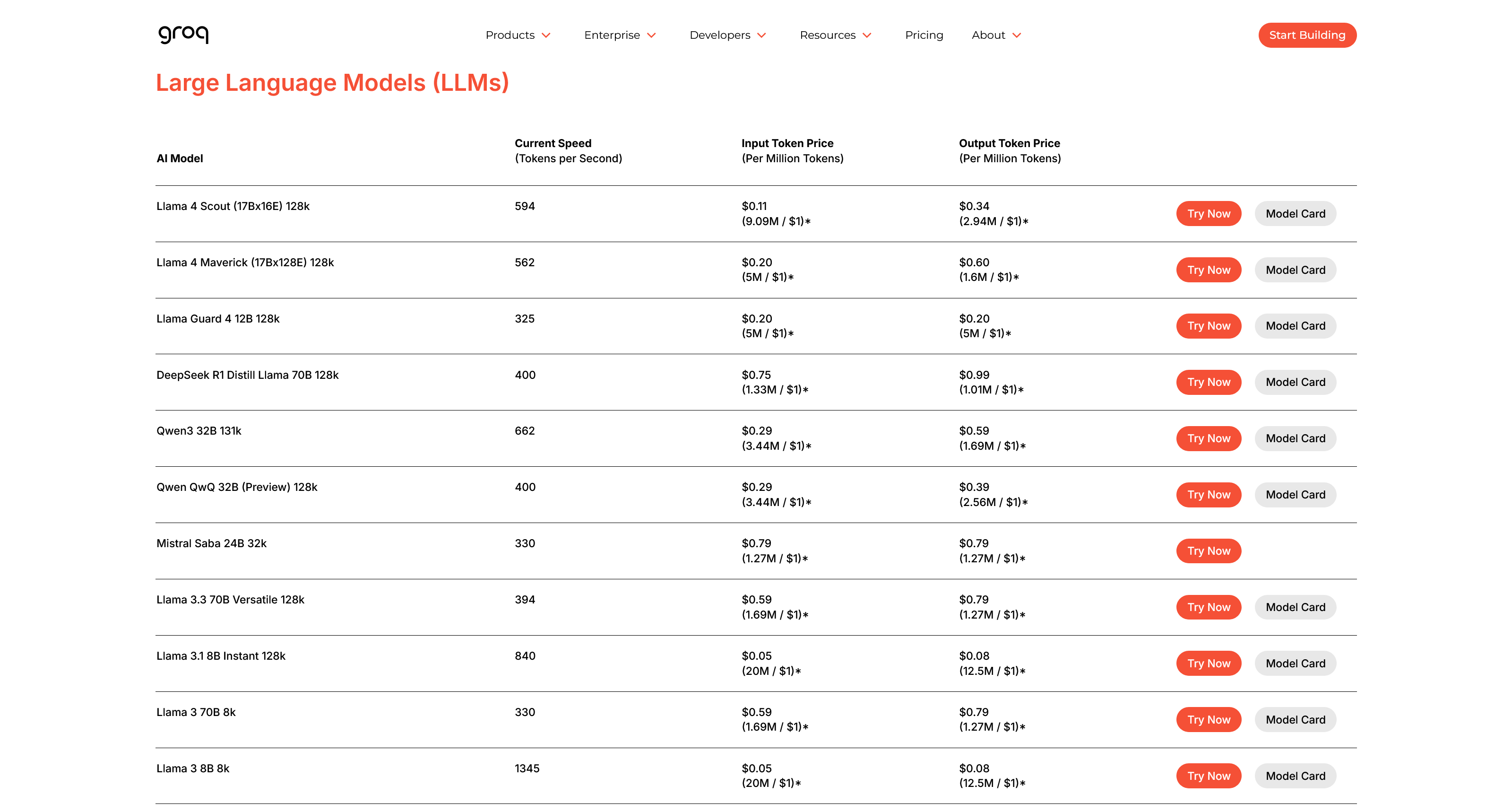

En sådan leverantör är Groq, kända för sin extremt höga hastighet. Med denna metod behöver du inte hyra en hel server. Istället har du AI "på kran" och betalar bara för exakt det du använder. Betalningsmodellen baseras nästan alltid på tokens – du betalar ett visst pris för de tokens du skickar i din förfrågan (input) och ett annat pris för de tokens du får tillbaka i svaret (output).

I bilden nedan ser vi ett utdrag från Groqs prislista. Den visar vad olika modeller kostar per en miljon input-tokens och en miljon output-tokens.

Vi kan dra ett par slutsatser från detta:

- Output är oftast dyrare än input. Det kostar mer för leverantören att generera ett svar än att bara ta emot en fråga.

- Större modeller kostar mer. Modeller med fler parametrar (som Llama 3 70B jämfört med 8B) har ett högre pris per token. Det är logiskt, eftersom de kräver kraftfullare servrar med mer VRAM för att köras.

Fördelar:

- Extremt Kostnadseffektivt (Pay-as-you-go): Du betalar endast för den datorkraft du faktiskt använder, ner på sekundnivå. Har din app inga användare under natten? Då är kostnaden noll. Detta är perfekt för startups och projekt med ojämn eller oförutsägbar trafik.

- Oslagbar Enkelhet och Snabbhet: Du kan gå från idé till fungerande prototyp på minuter. Du behöver inte kunna något om serverhantering eller optimering. Du hittar en modell, kopierar några rader kod, och din app kan plötsligt använda AI.

- Tillgång till Optimerade Modeller: Dessa företag är specialister. De kör ofta modellerna på den absolut bästa hårdvaran och har optimerat mjukvaran för maximal prestanda (hög hastighet, tokens/sekund).

Nackdelar:

- Låg Datakontroll och Säkerhetsrisk: Detta är den största nackdelen. All data du skickar måste lämna ditt system och processas av en tredje part. Detta alternativ är olämpligt för känslig data som patientjournaler eller företagshemligheter.

- Begränsat Modellutbud: Även om dessa plattformar erbjuder många populära modeller, så har de inte alla. Du är begränsad till den katalog som leverantören väljer att underhålla och förlorar friheten att kunna experimentera med exakt vilken modell du vill.

- Oförutsägbara kostnader vid framgång: "Pay-as-you-go" kan vara ett tveeggat svärd. Det är billigt att starta, men om din applikation plötsligt blir viral kan kostnaderna skena iväg explosionsartat och okontrollerat, vilket gör det svårt att budgetera.

Alternativ 4: De Stora Molnplattformarna

Här kliver vi in på de verkliga techjättarnas hemmaplan: Amazon Web Services (AWS), Google Cloud och Microsoft Azure. Dessa plattformar är inte bara leverantörer; de är hela ekosystem för att bygga och skala applikationer. När det kommer till AI erbjuder de en hybridliknande modell där du ofta kan välja mellan två vägar:

- Hyr en server: Du hyr dedikerad GPU-kraft (likt Alternativ 2) och har full kontroll över att installera och köra precis den AI-modell du önskar i deras molninfrastruktur.

- Använd en managerad tjänst: Du använder ett API för att få tillgång till en uppsjö av modeller som de redan har optimerat och förberett (likt Alternativ 3), via tjänster som AWS Bedrock, Google Vertex AI eller Azure AI Studio.

Att bygga på dessa plattformar kommer med en unik uppsättning för- och nackdelar.

Fördelar

- Enorm Skalbarhet och Tillförlitlighet: Dessa plattformar är byggda för att hantera trafik på en global skala. Du kan gå från tio användare till tio miljoner utan att din applikation kraschar. Med datacenter över hela världen garanterar de hög tillgänglighet och prestanda oavsett var dina användare befinner sig.

- Fullt Integrerat Ekosystem: Detta är den största styrkan. Din AI-modell kan sömlöst och effektivt kommunicera med alla andra delar av din applikation – din databas, din fillagring, din användarhantering – eftersom allt finns inom samma plattform. Det förenklar utvecklingen av komplexa system enormt.

- Säkerhet och Certifieringar i Världsklass: Även om man kan diskutera dataintegritet, är den tekniska säkerheten hos dessa jättar oöverträffad. De har tusentals anställda som bara jobbar med säkerhet och besitter en uppsjö av branschspecifika certifieringar (för t.ex. vård och finans) som är extremt svåra och dyra att skaffa på egen hand.

Nackdelar

- Kostnaden: De fördelar som plattformarna erbjuder, såsom global skalbarhet och avancerad säkerhet, har sitt pris. Man betalar en premie för den bekvämlighet och trygghet det innebär, vilket gör att det sällan är det billigaste alternativet.

- Dataintegritet: Du måste sätta full tillit till att dessa megaföretag hanterar din data korrekt enligt era avtal.

- Geopolitisk risk: Som vi sett i oroliga tider finns alltid en risk att länder kan blockera åtkomst till tjänster från andra länder, vilket kan bli ett jätteproblem om hela din verksamhet bygger på det.

Alternativ 5: Direkt från Källan (Proprietära API:er)

Det sista alternativet är för när bara det absolut bästa räcker: att gå direkt till källan. Här pratar vi om att använda API:er från de företag som faktiskt skapar de mest omtalade och kraftfulla modellerna, som OpenAI, Anthropic och Google.

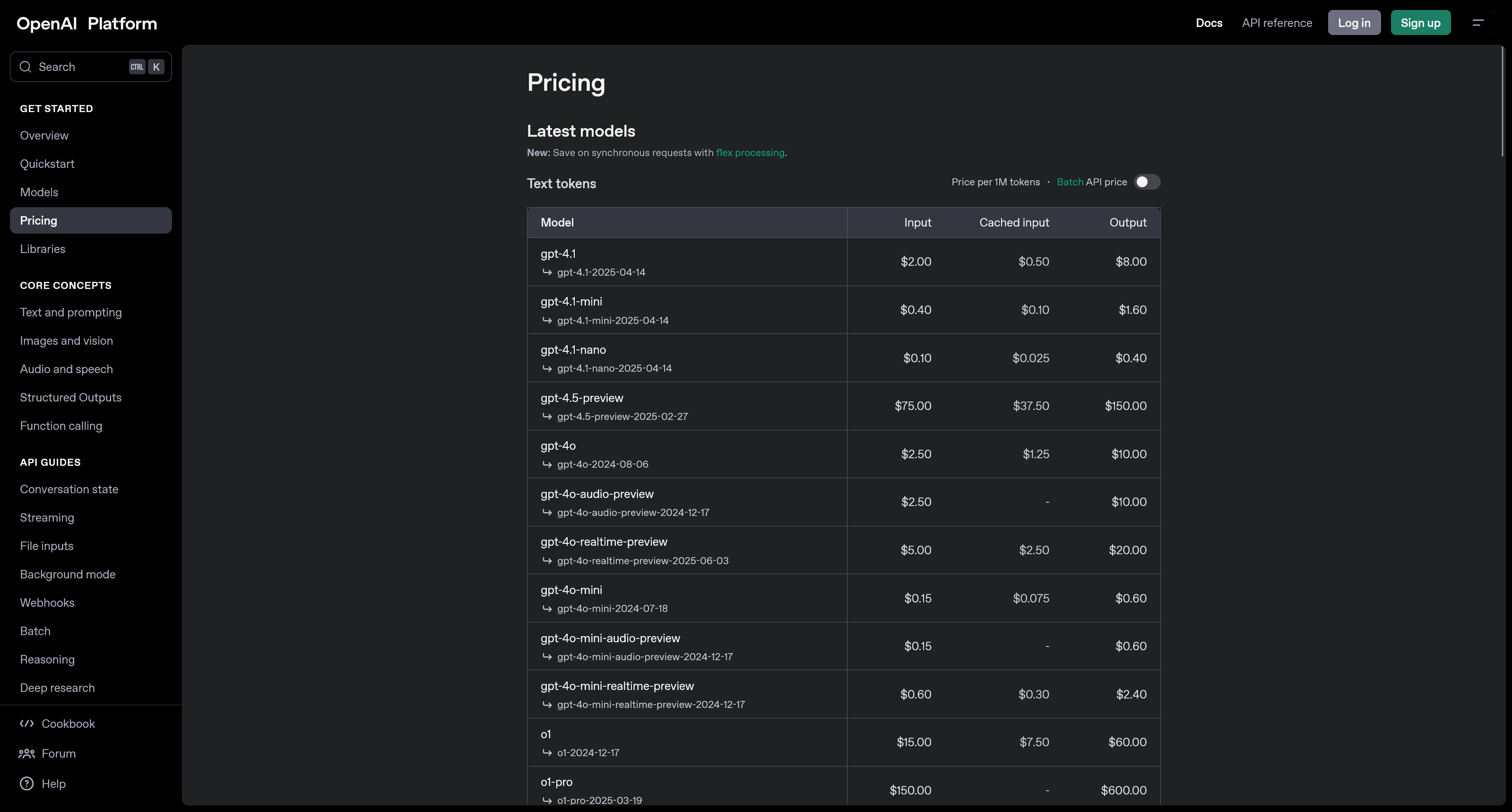

Detta liknar alternativ 3, men med den avgörande skillnaden att leverantören är exakt samma företag som skapat modellen. Istället för en katalog av olika open source-modeller får du här tillgång till ett företags specifika, ofta stängda och toppmoderna modeller. Om du till exempel går till OpenAI kan du via deras API använda exakt samma kraftfulla modeller som du kan chatta med i deras välkända tjänst ChatGPT – skillnaden är att du nu kan integrera kraften direkt i dina egna system, AI-agenter eller appar.

Precis som med andra API-tjänster betalar du per token, och priserna varierar beroende på modellens kapacitet.

Fördelar:

- Tillgång till Toppmoderna Modeller: Du får använda de allra senaste och mest kraftfulla modellerna (som GPT-4o, Claude 3.5 Sonnet) direkt när de släpps. Detta är modeller som är "state-of-the-art" och som inte finns tillgängliga för nedladdning.

- Unika Inbyggda Förmågor: Dessa API:er erbjuder ofta mer än bara text. De har avancerade, inbyggda funktioner för att förstå bilder och video, anropa externa verktyg, och söka på webben, allt paketerat i ett smidigt anrop.

- Minimalt Underhåll: Detta är den enklaste vägen. Du behöver inte tänka på någonting annat än att anropa deras API. Allt underhåll, all uppdatering och all drift av den underliggande superdatorn sköts helt av leverantören.

Nackdelar:

- Högst Kostnad: Att använda de bästa modellerna kostar. Detta är nästan alltid det dyraste alternativet per "token", och kostnaden kan snabbt bli mycket hög vid storskalig användning.

- Störst Dataintegritetsrisk: Du skickar din data direkt till AI-forskningslabbet som utvecklar modellen. Deras policyer tillåter ofta att de använder (anonymiserad) data för att träna framtida modeller, vilket är en stor risk för all känslig information.

- Innehållsfilter och Censur: Dessa kommersiella tjänster har starka, inbyggda filter för att förhindra olämpligt innehåll. Du har ingen kontroll över dessa filter, och de kan blockera legitima förfrågningar om de av misstag flaggas. Det är värt att notera att inte alla open source-modeller (som man kan köra lokalt) nödvändigtvis är ocensurerade, men det finns populära exempel som Dolphin, som är designade för att ge användaren full kontroll över modellens riktlinjer.

Sammanfattning: Vad ska man välja?

Som vi har sett finns det inget entydigt svar på var en AI-modell "bör" bo. Valet av driftsättningsmetod är en komplex balansakt som helt beror på dina unika behov och förutsättningar. Det finns inget alternativ som är bäst i alla lägen, utan varje metod har sina distinkta för- och nackdelar.

Är datasäkerhet och fullständig kontroll din högsta prioritet? Då är de lokala alternativen (1 och 2A), där du äger hårdvaran själv, oslagbara. Är istället tillgång till den absolut högsta prestandan och de senaste modellerna avgörande? Då kommer de proprietära API:erna (5) att vara det självklara valet. För den som söker en flexibel och skalbar medelväg kan hyrda servrar (2B), specialiserade API:er (3) eller de stora molnplattformarna (4) vara den perfekta kompromissen. Är budgeten en avgörande fråga, kolla gärna in vårt blogginlägg [platshållare] som går in i detalj på detta, där du även själv kan leka runt och testa olika budgetscenarion.

I tabellen nedan ser vi en kort jämförelse utifrån olika aspekter för att ge en snabb överblick.

| Metod | Startkostnad | Användningskostnad | Kvalitet | Integritet | Skalbarhet | Enkelhet | Latens | Underhållsbörda | Anpassningsbarhet |

|---|---|---|---|---|---|---|---|---|---|

| 1 Lokalt på enheten | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | ★★☆☆☆ | ★★★★★ | ★★★★☆ | ★★★★★ |

| 2A Egen server | ★☆☆☆☆ | ★★★★☆ | ★★★☆☆ | ★★★★★ | ★★☆☆☆ | ★☆☆☆☆ | ★★★★☆ | ★☆☆☆☆ | ★★★★★ |

| 2B Hyrd server | ★★★★★ | ★☆☆☆☆ | ★★★☆☆ | ★★★★☆ | ★★★☆☆ | ★★★☆☆ | ★★★☆☆ | ★★★☆☆ | ★★★★★ |

| 3 Inference-API | ★★★★★ | ★★★☆☆ | ★★★★☆ | ★☆☆☆☆ | ★★★★★ | ★★★★★ | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ |

| 4 Molnplattform | ★★★★☆ | ★★☆☆☆ | ★★★★☆ | ★★★☆☆ | ★★★★★ | ★★★★☆ | ★★★★☆ | ★★★★☆ | ★★★☆☆ |

| 5 Direkt-API | ★★★★★ | ★★☆☆☆ | ★★★★★ | ★★☆☆☆ | ★★★★★ | ★★★★★ | ★★★☆☆ | ★★★★★ | ★★☆☆☆ |

För en fullständig genomgång av alla alternativ, inklusive en detaljerad finansiell analys, se videon nedan.

Resurser

- Verktyg & Plattformar:

- Ollama - Kör språkmodeller lokalt.

- Hugging Face - Världens största samlingsplats för AI-modeller.

- Serveruthyrning (GPU):

- API-leverantörer:

- Övrigt: